начато: 25.07.2010

последнее изменение: 01.09.2013

http://handmade-linux-firewall.narod.ru

http://hlf.netii.net

Содержание

ВступлениеЧасть 1. Концепции

Что мы хотим

Схема сети

Почему рассматривается именно этот вариант схемы?

Проблемы

Основные концепции: потоки, линки, цепочки

Листинг правил iptables для рассматриваемой схемы сети

Конфигурация интерфейсов шлюза

Фильтрация

Сетевые сервисы или чего не должно быть на шлюзе/firewall'е

Контроль доступа

Цепочки фильтрации

Локальная сеть <-> шлюз

Интернет <-> шлюз

Локальная сеть <-> Интернет

Интернет <-> DMZ

Локальная сеть <-> DMZ

Фильтрация и отслеживание соединений (connection tracking)

Маршрутизация (routing)

Один провайдер

Два провайдера

Policy routing

fwmark: NETFILTER+routing

Этапы прохождения пакета через NETFILTER

Входящий трафик через двух провайдеров

Резервирование и переключение: динамическая маршрутизация?

Доступ из внутренних сетей к сети Интернет через один публичный адрес (NAT - трансляция адресов)

Управление трафиком (traffic control: shaping, policing и т.д.)

Управление исходящим трафиком: shaping, scheduling

Входящий трафик и почему им невозможно управлять. Policing

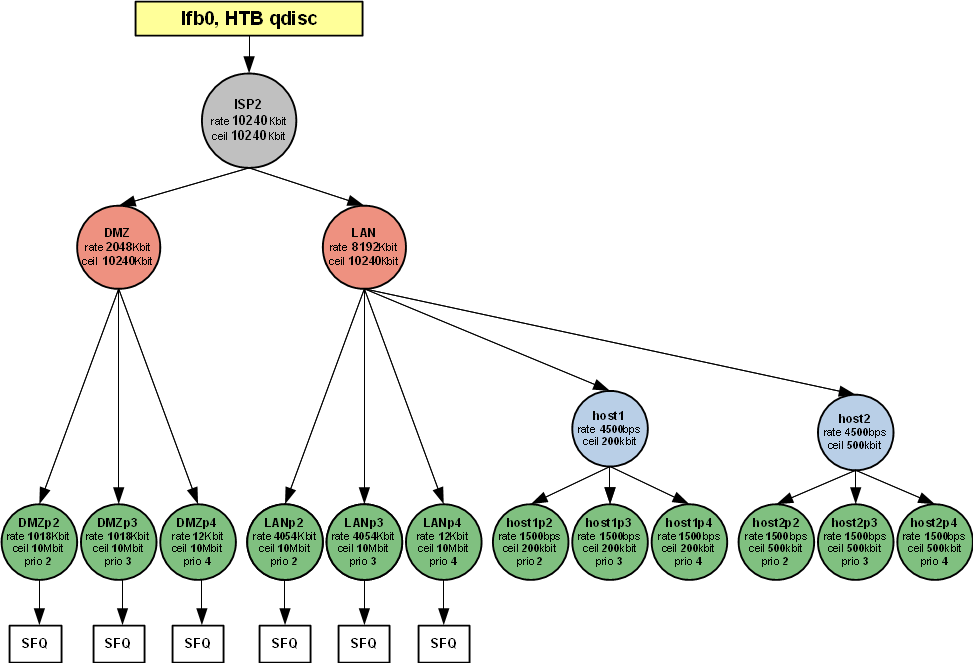

Управление трафиком в рассматриваемом примере

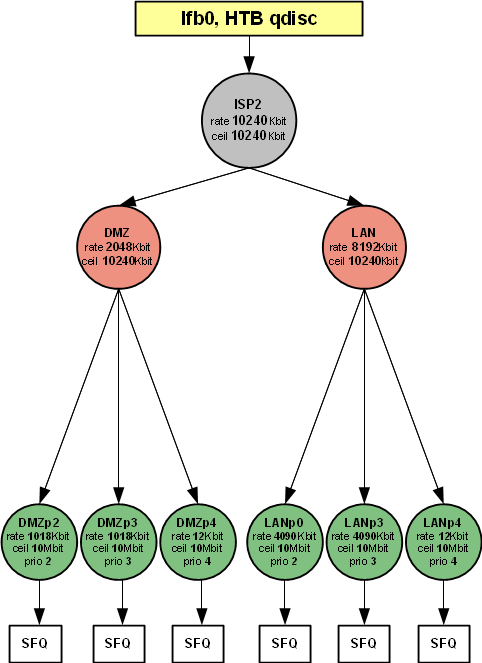

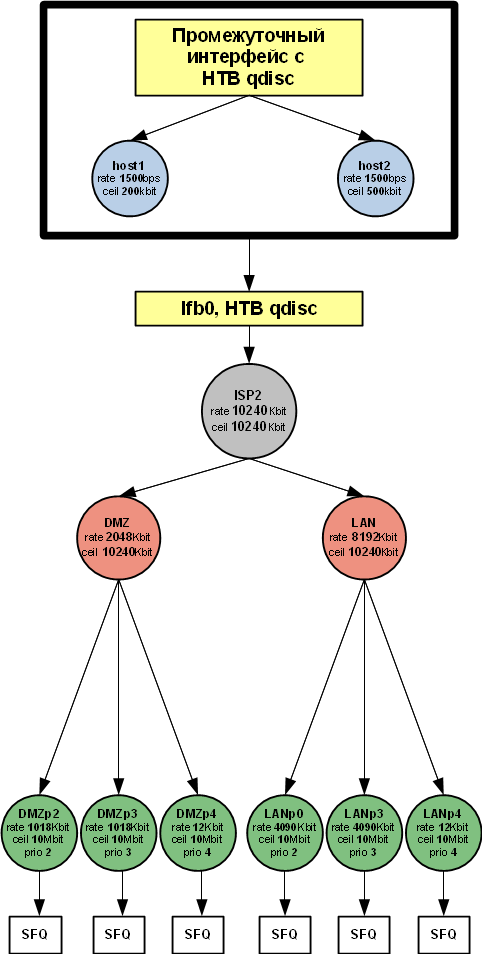

Объединённое управление трафиком на нескольких интерфейсах (IFB, IMQ - одна дисциплина на несколько интерфейсов)

Управление трафиком в downstream-канале

Обьединение трафика на виртуальном IFB-интерфейсе

Настройка дисциплины IFB-интерфейса и создание иерархии классов

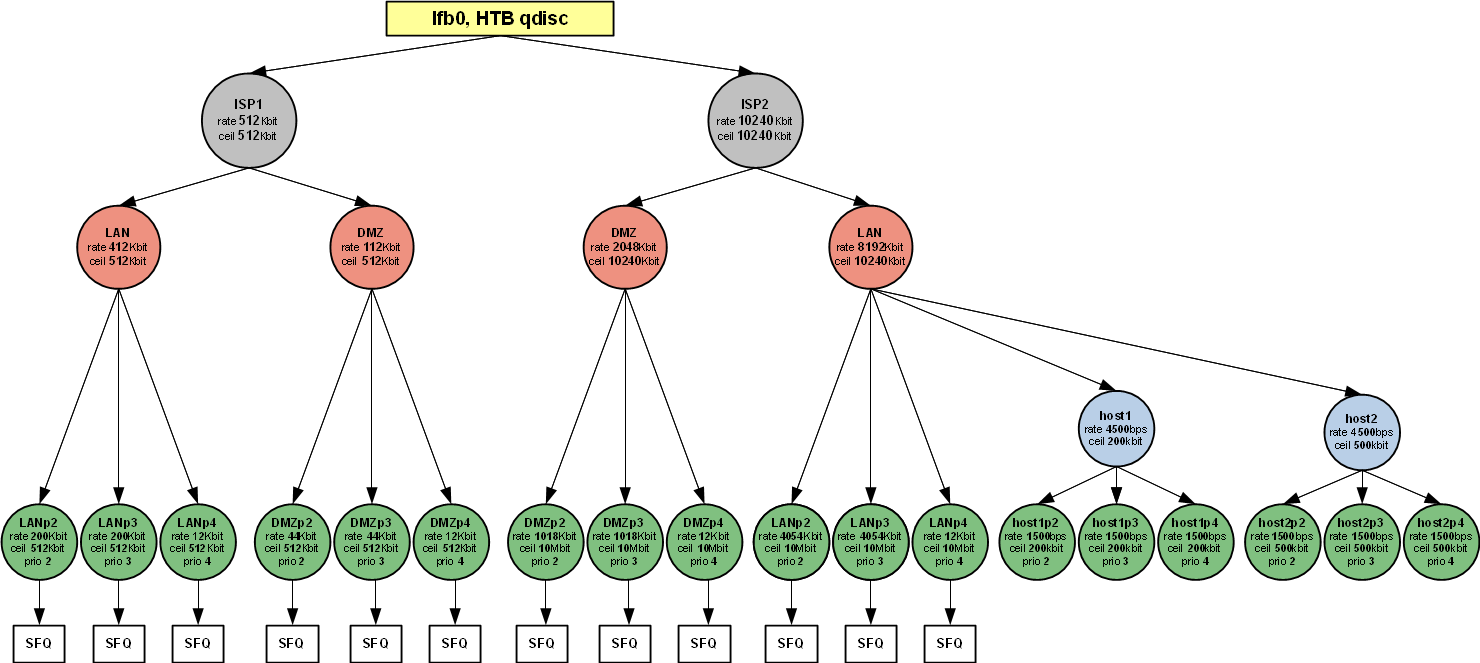

Иерархия классов для двух каналов/провайдеров

Классификация трафика при помощи NETFILTER

Управление трафиком и SQUID

Вариант №1: использовать возможности SQUID (версии 2.x) по управлению трафиком

Вариант №2: косвенное влияние на использование канала SQUID'ом плюс частичная "интеграция" с traffic control

Учет (подсчет) трафика (traffic accounting)

Подсчет трафика с помощью conntrackd

Подсчет трафика с помощью ulogd

Учет трафика и SQUID

Roadwarriors: мобильные клиенты. Доступ к внутренним сетям и VPN.

Функционирование VPN с точки зрения фаервола

VPN и маршрутизация

Выбор VPN

Использование ipset. Оптимизация набора правил

iptables-restore: атомарная загрузка набора правил

nftables: преемник iptables и будущее Linux firewall

Часть 2. Реализация

Чем не устроил Shorewall

Предыдущие варианты реализации или "как не надо делать"

Исходные тексты фаервола

Почему perl, а не bash, python и т.д.?

Почему конфигурация не хранится в СУБД или LDAP

Устройство фаервола

Структура каталогов

Поддержка нескольких конфигураций

Общие модули

Конфигурационные файлы

Файл описания шлюза и сетей

Синтаксис файла

Файл описания правил для хостов и сетей

Синтаксис файла

Конфигурация main

Процесс загрузки конфигурация main

Подробнее о функциях firewall.pm

Вопросы без ответов

TODO

Вступление

В данном тексте показан один из возможных вариантов построения интернет-шлюза (небольшой организации) на базе GNU/Linux с функциями фаервола, маршрутизатора. В качестве дистрибутива используется Debian GNU/Linux.

Представлена целостная картина, основанная на реально эксплуатируемой системе.

Изложен один из возможных принципов организации правил NETFILTER, позволяющие относительно легко:

- разработать набор правил

- осуществлять визуальный анализ их логики (по выводу iptables -nvL)

- вносить изменения в конфигурацию фаервола

- автоматизировать фаервол.

Также рассмотрены: маршрутизация (напр. работа через двух провайдеров), управление трафиком, учет трафика, разъяснены некоторые неочевидные моменты, с которыми пришлось столкнуться на практике.

Текст ориентирован на тех, кто хочет увидеть пример реально эксплуатирумого набора

правил iptabels/tc (плох он или хорош - это другой вопрос), разобраться в работе и использовании

подсистем фаервола и управления трафиком в Linux с целью самостоятельного конфигурирования.

Подразумевается, что вы представляете, как продвинутый пользователь/администратор,

что такое iptables, знаете синтаксис команд iptables, в общих чертах возможности NETFILTER

(подсистема ядра для перехвата пакетов и выполнения манипуляций над ними),

сетевого стека Linux в целом, знаете о IP, UDP/TCP и т.д. и т.п.

Т.е. у вас есть знания о составных частях, но вы смутно представляете себе, как

из этого всего собрать, нечто, решающее сетевые задачи в комплексе.

Текст состоит из двух частей.

В первой части описаны предлагаемые принципы организации правил для фаервола (NETFILTER) и

управления трафиком (TRAFFIC CONTROL), а также взаимодействие этих подсистем.

Во второй части представлена и описана реализация фаервола на основе принципов, изложенных в первой части. Представлен и описан реально эксплуатируемый исходный код, который, посредством настройки и/или относительно легкой модифицикации, можно подстроить под конкретные нужды.

Если необходимо готовое, широко используемое решение - смотрите Shorewall http://www.shorewall.net (есть в большинстве дистрибутивов) или специализированные дистрибутивы-фаерволы/маршрутизаторы: IPCop, IPFire и т.п. (List of router or firewall distributions)

Если вы недостаточно понимаете возможности iptables - есть отличная документация по возможностям

и синтаксису, правда на английском -

"Iptables Tutorial", http://www.frozentux.net/iptables-tutorial/iptables-tutorial.html.

Есть русский перевод устаревшей версии: http://www.opennet.ru/docs/RUS/iptables/

Часть 1. Концепции

Что мы хотим

Условимся подконтрольные нам сети называть "внутренними сетями", а сети, которые не находятся под нашим управлением - "внешними сетями". В простейшем случае: все что в офисе - "внутренняя сеть", Интернет - "большая внешняя сеть".

В рассматриваемом случае шлюз выполняет роль фаервола, маршрутизатора и, возможно, на нём функционируют какие-либо сетевые сервисы.

Итак, есть общая задача - организовать одновременный доступ нескольких узлов (хостов, компьютеров, устройств) из внутренних сетей к сети Интернет через один публичный IP-адрес. Также, необходимо организовать инфраструктуру под собственные web/ftp/smtp/pop-сервера с возможностью доступа к ним из внешних сетей. Дополнительно, небходимо обеспечить возможность доступа к другим внешним сетям через дополнительные интерфейсы шлюза и доступ в сеть Интернет через второго провайдера.

Уточним требования к шлюзу и задачи которые мы хотим решить:

- задачи:

- организовать доступ из внутренних сетей к сети Интернет (и другим внешним сетям) через один публичный адрес (а-ля "чтобы все в офисе могли лазить по Интернету")

- в случае двух внешних сетей, имеющих выход в Интернет, маршрутизировать (направлять) исходящий трафик (согласно каким-то критериям) по разным путям (через разных провайдеров) (а-ля "чтобы Вася лазил в Интернет через провайдера X, а Петя, в то же время, через провайдера Y")

- контролировать доступ из внутренних сетей к узлам внешних сетей на уровне пользователей, адресов узлов, протоколов, tcp/udp-портов (а-ля "Петя может лазить везде,Васе только ICQ, а Маше вообще в Инете делать нечего")

- ограничивать скорость передачи данных между внешними и внутренними сетями (download и upload) на уровне пользователей, адресов узлов, протоколов, tcp/udp-портов (а-ля "Петя может качать со скоростью 100 кбайт/с, а Вася 200 кбайт/с")

- организовать доступ из внешних сетей к внутренним сетям с контролем доступа на уровне пользователей, адресов узлов, протоколов, tcp/udp-портов (а-ля "чтобы сотрудник мог подключиться к нашей сети из дома/командировки (через VPN)" и "чтобы люди могли заходить на наш сайт, почта была у нас и "ходила" от нас и к нам")

- требования:

- относительно простой визуальный анализ логики правил

- относительно простое (не требующее длительного анализа последствий, предсказуемое) внесение изменений в конфигурацию фаервола

- возможность перезапуска "по частям", т.е. чтобы при изменении конфигурации можно было обновлять не все правила, а только часть правил, соответствующих изменениям в конфигурации следующие требования относятся в большей степени к реализации как таковой:

- интеграция решаемых задач (контроль доступа и управление трафиком) в единое целое для упрощения администрирования и наглядности конфигурации

- желательно наличие конфигурационных файлов, позволяющих задать необходимые метаданные (имена узлов, ФИО сотрудников и т.п.)

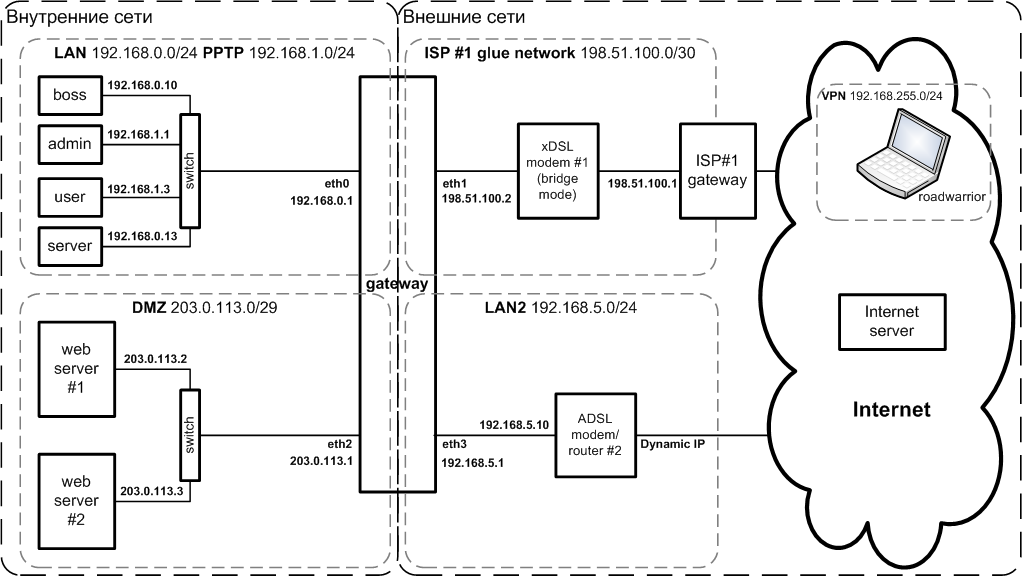

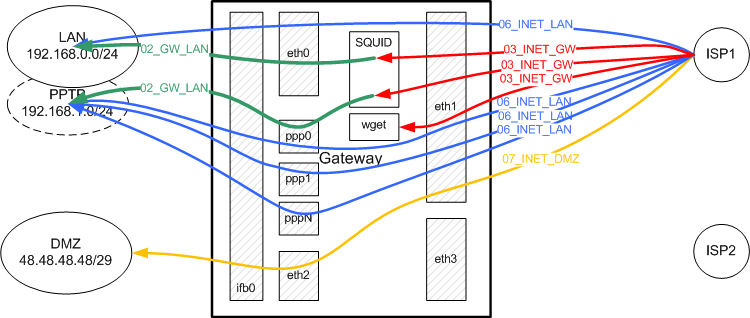

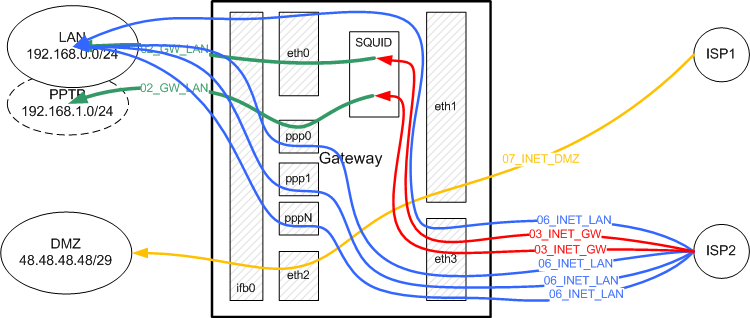

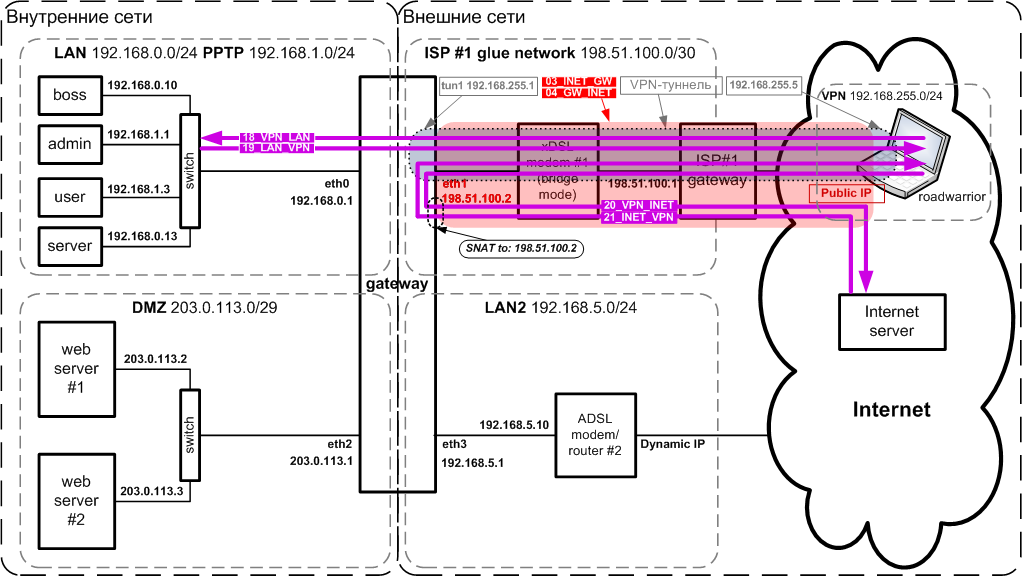

Схема сети

Ниже приведена схема сети, которая будет рассматривать в дальнейшем:

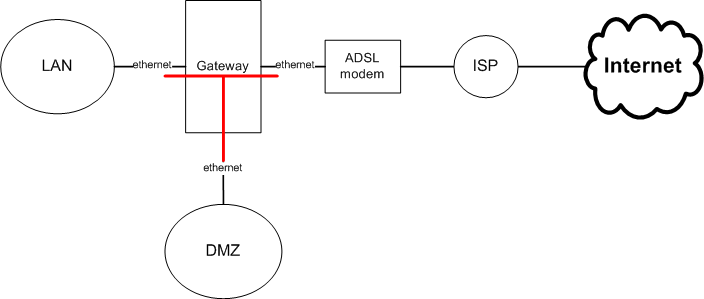

В общем, схема представляет собой классический "three-legged" ("Т-образный") firewall с выделением сервисов, доступных извне в отдельную сеть DMZ (от "Демилитаризованная зона"), которая подключена к отдельному интерфейсу (т.е. сетевой карте).

Чтобы лучше была видна "Т-образность" фаервола, ниже приведена слегка упрощенная схема (без подключения ко второму провайдеру).

Теперь рассмотрим схему сети на Рис.1 подробнее:

Территориально в Здании 1 расположены:

- LAN - наша локальная сеть, в которой расположено все наше оборудование (компьютеры), которое должно быть недоступно напрямую (по IP-адресам) извне;

- PPTP - виртуальная сеть поверх физичеcкой сети LAN - служит для контроля доступа из внутренних сетей во внешние: чтобы "выйти в Интернет" надо установить PPP-туннель к шлюзу;

- DMZ - демилитаризованная сеть, в которой расположено оборудование,

которое должно быть доступно извне (web/ftp/почтовый сервера).

Возможны два варианта: - сеть DMZ имеет публичные адреса выделенные провайдером - нужна только маршрутизация;

- сеть DMZ имеет private адреса - нужны: маршрутизация + SNAT + DNAT + port forwarding;

- ADSL модем №1, подключеный одним портом к шлюзу Gateway, а другим - к сети провайдера ISP1, например по телефонной линии;

- Gateway - собственно шлюз: компьютер с ОС Linux, 4-мя сетевыми интерфейсами (сетевыми Ethernet-картами). Шлюз выполняет роль маршрутизатора, фаервола, а также, на нем могут функционировать некоторые сервисы. Именно через него проходит весь трафик между сетями и именно здесь сосредоточены функции управления и контроля. На шлюзе:

- к интерфейсу eth0 через коммутатор (switch) подключена сеть LAN;

- к интерфейсу eth1 подключен (своим Ethernet-портом) ADSL модем №1, Интерфейс имеет статический IP-адрес, выданный провайдером ISP1;

- к интерфейсу eth2 через коммутатор (switch) подключен сеть DMZ;

- к интерфейсу eth3 через коммутатор (switch) подключена сеть LAN2;

Территориально в Здании 2 расположены:

- неподконтрольная, но доступная нам локальная сеть LAN2: нам выделен один адрес для подключения шлюза Gateway. Сеть LAN2 имеет выход в Интернет через ADSL модем №2

- ADSL модем №2, подключенный одним портом к сети LAN2, а другим - к к провайдеру ISP2 (например по телефонной линии). Внешний интерфейс имеет динамический IP-адрес, выдаваемый провайдером ISP2 при подключении. Есть возможность напрямую или через администратора сети LAN2 настраивать маршрутизацию на ADSL модеме №2;

- roadworrior - мобильные сотрудники, находящиеся вне внутренних сетей (командировка, дом) и желающие получить доступ в сеть LAN (и возможно в LAN2).

Почему рассматривается именно этот вариант схемы?

Естественно реальная сеть, являющася прототипом рассматриваемой здесь сети, развивалась от простого к более сложному. Сначала была сеть LAN и один провайдер ISP1. Далее потребовалось контролировать доступ из сети LAN в Интернет - был выбран PPTP и появились pppN интерфейсы. Затем появилась необходимость в размещении собственных сервисов - для этого появилась сеть DMZ. Позже появилось подключение к сети LAN2 и выход через неё на второго провайдера ISP2. Соответственно, росло и количество интерфейсов.

С другой стороны, рассматриваемый вариант удобен тем, что он имеет достаточную сложность, чтобы проявилась значительная часть вопросов и проблем, возникающих при управлении фаерволом на таком шлюзе.

Проблемы

Как организовать последовательность правил для фаервола? По какому принципу? Чтобы это было удобно и наглядно. В NETFILTER есть пять встроенных цепочек:

- INPUT - для всех входящих (через любой интерфейс) пакетов, предназначенных для данного узла (т.е. после процесса маршрутизации);

- OUTPUT - для всех исходящих через все интерфейсы пакетов ещё до процесса маршрутизации;

- FORWARD - для всех проходящих (из любого - в любой интерфейс) пакетов;

- PREROUTING - для всех входящих (через любой интерфейс) пакетов, ещё до процесса маршрутизации;

- POSTROUTING - для всех исходящих (через любой интерфейс) пакетов уже после процесса маршрутизации.

Чаще всего, в примерах и HOWTO встречается такой подход: правила фильтрации помещаются в эти цепочки "все в кучу" - одно за одним: все правила для фильтрации входящих пакетов на все интерфейсы - в INPUT, все правила для фильтрации исходящих пакетов из всех интерфейсов - в OUTPUT. Или: все разрешающие правила - в одну пользовательскую цепочку, все запрещающие - в другую цепочку. Или: все правила для tcp - в одну цепочку, для udp - в другую, для icmp - в третью и т.п. (см. тот же "Iptables Tutorial"). Изредка вводятся какие-то цепочки для решения каких-то частных задач и только. Достаточно универсальная методика не предлагается - в основном какие-то фрагменты, из которых трудно "сложить" что-то "внятное".

Такой подход к организации последовательности правил приводит к ряду сложностей:

- правила изначально трудно планировать и разрабатывать: неочевидно какого принципа придерживаться, какие правила должны идти раньше, какие - позже; со временем это 100%-но превращается в неуправляемый "бардак" и поэтому;

- правила трудно анализировать: выяснить (вспомнить) "что я тут накрутил?";

- правила трудно модифицировать: вам надо внести изменения, и для этого вам сначала надо вспомнить "что я тут накрутил?";, потом долго думать "куда же мне воткнуть эти новые правила?", а затем еще дольше анализировать: "будет ли это работать нужным образом после внесения изменений?" и "не нарушу ли я то, что раньше работало?";

- правила трудно автоматизровать: для бессиcтемных наборов правил труднее написать некий скрипт, автоматизирующий создание нужной логики на основе неких конфигурационных файлов.

Основные концепции: потоки, линки, цепочки

Косвенно о применимости данного подхода намекает cуществование "Strict Reverse Path Forwarding" в RFC 3704 - Ingress Filtering for Multihomed Networks:

Strict Reverse Path Forwarding is a very reasonable approach in front of any kind of edge network; ... First, the test is only applicable in places where routing is symmetrical - where IP datagrams in one direction and responses from the other deterministically follow the same path. While this is common at edge network interfaces to their ISP, it is in no sense common between ISPs, which normally use asymmetrical "hot potato" routing.

В целом, в RFC 3704, речь идет о защите от трафика с поддельных адресов путем проверки на маршрутизаторе маршрутизации до адреса-источника. Адрес-источника в получаемом пакете проверяется по FIB и если пакет был получен через тот же интерфейс, через который будет маршрутизироваться ответ к этому адресу, то всё ок. Иначе пакет можно игнорировать. Естественно это работает только при симметричной маршрутизации, которая используется при подключении клиента к провайдеру (т.е. наш случай).

- Потоком (flow)

-

условимся называть однонаправленный логический канал передачи данных между

двумя сетями или сетью и шлюзом. С учетом того, что:

- физически трафик между сетями проходит не напрямую, а через шлюз;

- в одну и ту же сеть (напр. INET) трафик может идти через разные интерфейсы шлюза;

- трафик в разные сети может идти через один и тот же интерфейс шлюза (напр. в LAN2 и INET через eth3),

- cеть источник,

- входной интерфейс на шлюзе,

- выходной интерфейс на шлюзе,

- сеть приёмник.

Далее по тексту потоки будут обозначаться следующим образом:

- сеть_источник>вх_интерфейс-исх_интерфейс>сеть_приёмник обозначает один конкретный поток. Например LAN>eth0-eth3>INET, LAN>eth0-GW;

- сеть_источник>сеть_приёмник обозначает все потоки (через все интерфейсы) между двумя сетями, идущие в одном направлении. Например LAN>INET, INET>GW;

- сеть_источник-сеть_приёмник обозначает все потоки (в прямом и обратном направлениях) между двумя сетями; Например LAN-INET, INET-GW.

- Из двух потоков, поток считающийся прямым, выбирается произвольно. Обратным же для прямого, будет поток, в идентификаторе которого входящие и исходящие сеть и интерфейс зеркально переставлены местами.

- Линком, связью (link)

- в данном тексте условимся называть совокупность всех потоков (прямых и обратных через все интерфейсы) между двумя сетями или сетью и шлюзом.

- Цепочкой потока (flow chain)

- будем называть пользовательскую цепочку, в которой сгруппированы правила, предназначенные для управления пакетами данного потока.

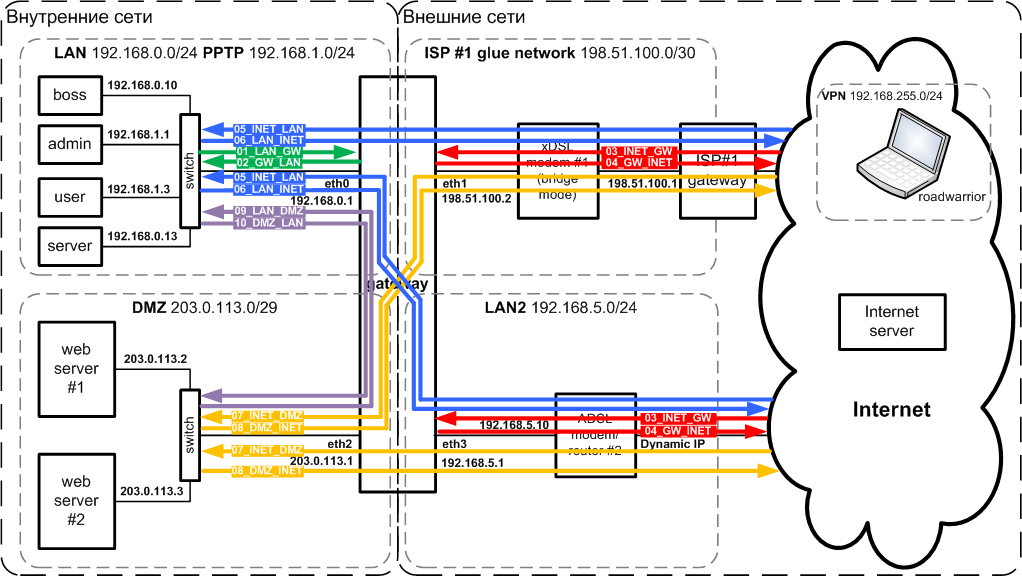

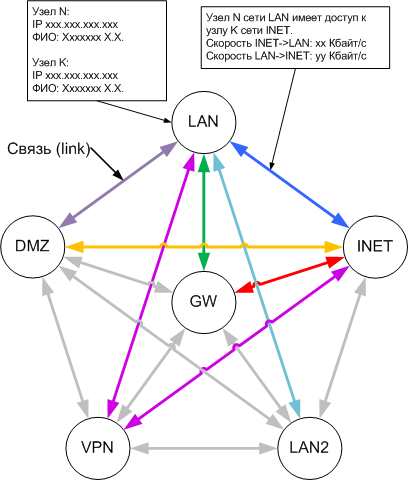

На рис.3 показаны основные потоки. Потоки относящиеся к одному линку имеют один цвет. Неиспользуемые или второстепенные потоки не показаны, чтобы не загромождать схему. Потоки между VPN и другими сетями показаны в разделе Функционирование VPN с точки зрения фаервола. Каждая стрелка соответствует потоку, а название стрелки - имени цепочки в правилах фильтрации.

Из схемы видно, что, например, линк LAN-DMZ состоит из двух потоков:

- LAN>eth0-eth2>DMZ - прямого и

- DMZ>eth2-eth0>LAN - обратного.

- LAN>eth0-eth1>INET - прямой,

- LAN>eth0-eth3>INET - прямой,

- INET>eth1-eth0>LAN - обратный,

- INET>eth3-eth0>LAN - обратный,

- LAN>ppp+-eth1>INET - прямой,

- LAN>ppp+-eth3>INET - прямой,

- INET>eth1-ppp+>LAN - обратный,

- INET>eth3-ppp+>LAN - обратный.

В случаях когда сетью источником/приемником является сам шлюз,то входной/выходной интерфейсы не имеют смысла, например для линка LAN-GW:

- LAN>eth0-GW - прямой поток,

- GW-eth0>LAN - обратный.

Выше была показана только часть существующих между сетями потоков.

Посмотрим, сколько всего потоков в рассматриваемой конфигурации.

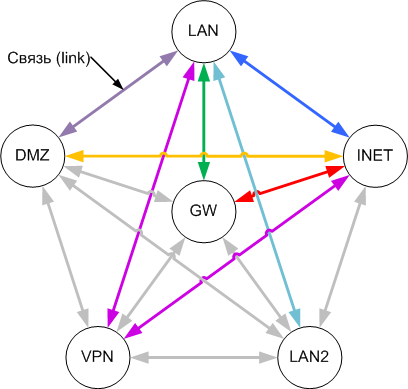

Представим схему сети в виде графа (рис. 4), в котором шлюз и сети представлены вершинами.

Соединим каждую вершину со всеми остальными - получим полный граф со всеми

возможными линками (ребра графа) между пятью сетями. Цвет линков на рис. 4

соответствует цветам на рис. 3. Серым цветом показаны неиспользуемые линки -

трафик между этими сетями нам не нужен и поэтому не разрешён.

Кол-во линков будет равно N*(N-1)/2, где N - кол-во вершин в графе.

Для рассматриваемой сети N=6 и кол-во линков равно 15.

Т.к. линк состоит как минимум из двух потоков - прямого и обратного, то

минимальное кол-во всех потоков будет равно 30.

Однако это еще не всё. Сеть LAN у нас "синтетическая" и фактически объединяет две разных IP-сети на двух разных интерфесах - eth0 и ppp+. С сетью INET похожая ситуация - доступ в сеть INET тоже возможен через два интерфейса - eth1 и eth3. Поэтому если мы хотим посчитать абсолютно все варианты обмена трафиком, то граф должен содержать все сочетания сеть-интерфейс: LAN-eth0, LAN-ppp+, INET-eth1, INET-eth3, LAN2-eth3, VPN-tun1, DMZ-eth2, GW или что то же самое все интерфейсы шлюза плюс сам шлюз. Получаем 7 интерфейсов плюс сам шлюз и полное кол-во потоков 7*8=56. Максимальное же кол-во потоков для графа на рис. 3 будет равно 52, т.е. меньше на 4 потока: LAN>eth0-ppp+>LAN, LAN>ppp+-eth0>LAN и INET>eth1-eth3+>INET, INET>eth3-eth1>INET.

Теперь переходим к предлагаемому приниципу организации правил.

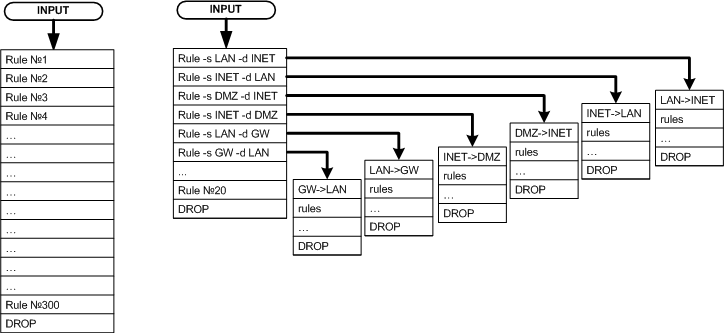

Основной подход в организации правил - вместо линейной последовательности правил использовать ветвление: каждому потоку - своя пользовательская цепочка (цепочка потока). Пакет "направляется на проверку" в ту или иную пользовательскую цепочку на основании принадлежности к одному из потоков.

Схематично это можно изобразить следующим образом:

- идентифицируем все возможные связи между сетями и между сетями и шлюзом

- для каждого реально используемого соединения создаем по две (для прямого и обратного потока) отдельных цепочки с информативными именами

- правила, относящиеся к соответствующему потоку помещаем в соответствующую цепочку (т.е. в цепочку потока)

- во встроенных цепочках INPUT, OUTPUT, FORWARD создаем только правила переходов в соответствующие цепочки потоков

- используем данный подоход как для фильтрации (в filter table), так и модификации (напр. MARK, CLASSIFY) пакетов (mangle table)

В случае необходимости иметь единый набор правил для разных потоков достаточно направить пакеты, принадлежащие разным потокам, в одну и ту же цепочку потока. Например, в рассматриваемом примере, правила фильтрации одинаковы для трафика между сетями LAN и Интернет вне зависимости от того каким путём он идет: через eth0 или ppp+ и eth1 или eth3. Или, например, трафик между сетями LAN, PPTP и шлюзом GW будет обрабатываться одинаково, как будто LAN, PPTP - одна сеть.

Ниже приведены ссылки на листинги правил фаервола для данной схемы, которые будут рассматриваться далее по тексту.

Конфигурация интерфейсов из файла /etc/network/interfaces

/etc/network/interfaces allow-hotplug eth0 eth1 eth2 eth3 ### LAN auto eth0 iface eth0 inet static address 192.168.0.1 netmask 255.255.255.0 network 192.168.0.0 broadcast 192.168.0.255 ### INET auto eth1 iface eth1 inet static address 198.51.100.2 netmask 255.255.255.252 network 198.51.100.0 broadcast 198.51.100.3 gateway 198.51.100.1 ### DMZ auto eth2 iface eth2 inet static address 203.0.113.1 netmask 255.255.255.248 network 203.0.113.0 broadcast 203.0.113.7 ### LAN2 auto eth3 iface eth3 inet static address 192.168.5.1 netmask 255.255.255.0 network 192.168.5.0 broadcast 192.168.5.255

Какие плюсы и минусы имеет такой принцип организации правил? На мой взгляд следующие:

- сразу просматривается некая логика которой можно следовать на протяжении всего жизненного цикла фаервола;

- довольно легко разработать, анализировать и модифицировать правила - просто выбираем, по какому потоку мы хотим что-то сделать - и "лезем" только туда, практически не боясь затронуть логику, действующую по другим потокам; меньше вероятность ошибок - мы знаем, что в данной цепочке будут проверяться только пакеты относящиеся к данному потоку;

- появляется возможность легко выборочно перезапускать firewall, т.е. обновлять правила "на лету" только по выбранному потоку, не затрагивая остальные;

- предположу, что такая организация правил ускоряет проверку пакетов: вместо проверки пакета по линейному списку, состоящему из всех правил, происходит определение нужной группы правил на основании сетей и интерфейсов пакета и, как следствие, существенное сужение списка проверяемых правил; хотя тут многое зависит от того сколько проверок потребуется для данного конкретного пакета и от соотношения количества цепочек, определяющих принадлежность и количества правил в цепочках потоков;

- единственным "недостатком" можно считать то, что количество потоков быстро растет с увеличением количества интерфейсов на шлюзе и контролируемых сетей, однако этот вопрос легко решается автоматизацией - описываем сети, а скрипт создает нужные цепочки; 4-ре интерфейса, пожалуй, разумный максимум для полностью ручного написания и модификаций правил фаервола;

Фильтрация

Одна из основных задач фаервола - пропускать разрешенный трафик и блокировать нежелательный, т.е. фильтровать входящий, исходящий, проходящий трафик. Для правил фильтрации в NETFILTER есть таблица filter - именно в неё добавляются правила, если в команде iptables явно не указана желаемая таблица. Однако, технически, правила фильтрации можно размещать в любых таблицах. В этой части будут показаны реально используемые правила фильтрации, но сначала важно разобраться, какие сетевые сервисы могут присутствовать на шлюзе, а какие там совершенно неуместны.

Сетевые сервисы или чего не должно быть на шлюзе

Максимум, что можно допустить на шлюзе - аутентификация межсетевого доступа пользователей. И даже это желательно выносить на отдельный сервер аутентификации. Все сетевые сервисы потенциально уязвимы и через них шлюз может быть взломан и как результат - может быть получен контроль над шлюзом и доступ во все сети. Для уменьшения вероятности взлома шлюза через сетевые сервисы их (сервисы) выносят на отдельные узлы (серверы) в отдельную, частично изолированную, сеть - DMZ.

На шлюзе правила фильтрации настраивают таким образом, что подключения, инициируемые из сети LAN в DMZ - разрешены, а вот соединения инициируемые из сети DMZ в LAN - блокируются! Таким образом, при взломе сервиса, работающего на сервере в DMZ, уменьшаются последствия взлома - напрямую со взломанного сервера невозможно будет подключиться к изолированой сети LAN. Это и есть функция сети DMZ.

Однако в реальности, по разным организационно-финансовым причинам, не всегда есть возможность вынести сетевые сервисы (web/ftp/smtp/pop3/dns и т.п.) в отдельную сеть. Поэтому не остается ничего другого, как ставить их на единственном сервере - шлюзе.

Размещать (все) сервисы непосредственно на шлюзе можно, если вы считаете что риски, связанные с таким подходом, являются приемлемыми. Например, вы считаете вероятность взлома низкой, или потери от утечек и восстановления работоспособности не существенными.

Конкретно в нашем примере, сервисы расположены на шлюзе и только web-сервер вынесен в DMZ. Поэтому на шлюзе есть открытые порты.

Контроль доступа

Для контроля доступа на уровне адресов хостов, протоколов, tcp/udp-портов достаточно возможностей одного NETFILTER. Контроль сводится к фильтрации (блокированию) нежелательного трафика по IP и/или MAC адресам.

Но надо понимать, что и IP-адрес и MAC-адрес любого устройства в сети могут быть изменены на адреса, которым разрешен доступ в контролируемую сеть (т.е. подделаны). Таким образом контроль доступа только по адресам не является абсолютно надежным, но на практике часто этого достаточно. Для более надежного контроля надо использовать какие-либо варианты аутентификации и авторизации трафика, проходящего через шлюз. Для этого можно использовать VPN или более специализированные решение, например NuFW.

PPTP VPN

В качестве VPN довольно удобно использовать PPTP: сервер есть под Linux, а клиент встроен во все версии Windows.

Для выхода в контролируемую сеть (например из LAN в Internet), пользователь должен создать туннель между своим устройством (компьютером) и сервером PPTP на шлюзе. Для этого он должен пройти аутентификацию по логину/паролю: получить доступ в контролируемую сеть без аккаунта невозможно. Естественно на шлюзе правила фаервола запрещают прохождение пакетов c адресов 192.168.0.0/24 сети LAN в контролируемую сеть. Зато там есть разрешающие правила для клиентских адресов pptp-тунеллей 192.168.1.xxx. Если пользователь пройдет процесс аутентификации, то будет создан туннель между его компьютером и шлюзом. На стороне шлюза туннелю будет присвоен адрес 192.168.3.1, а клиентской части туннеля - некий адрес, привязанный к логину и задаваемый в например /etc/ppp/chap-config. Т.о. создается устойчивое соотвествие "пользователь" - "IP адрес туннеля" и на шлюзе появляется возможность управлять доступом и другими параметрами подключения на основе IP-адреса клиентской стороны туннеля с помощю NETFILTER. Т.е. контроль на шлюзе и в этом случае происходит "естественным способом" - по IP-адресам. Только в этом случае адрес "защищен от подмены" логином/паролем.

OpenVPN

Для тех же целей можно использовать и OpenVPN.

Можно отключить шифрование, уменьшив нагрузку на шлюз. Недостатком этого варианта

является необходимость установки OpenVPN-клиента на клиентское устройство.

Для мобильных устройств с определенными ОС это может быть проблемой.

Также см. Выбор VPN

NuFW

Работа NuFW основана на другом принципе. На firewall устанавливается Nufw-сервер, который принимает пакеты от клиентов. На этом же хосте (или на другом) ставится сервер аутентификации Nuauth. На каждом клиентском хосте (компьютере) ставится Nufw-клиент. Каждый пакет исходящий от клиента принимается Nufw-сервером и ставится в очередь в ожидании аутентификации. Об этом пакете информируется Nuauth, который, в свою очередь, запращивает у соответствующего Nufw-клиента аутентификационные данные. Nufw-клиент запрашивает прохождение данного пакета у Nuauth и если пакет авторизован - передает разрешение на Nufw-сервер, который и "пропускает" пакет.

Nufw для своей работы использует NETFILTER: пакеты, подлежащие авторизации, просто направляются в определенную userspace (пространство пользователя) очередь при помощи target NFQUEUE, т.е. в очередь которой управляет Nufw-сервер. В случае удочной авторизации пакета, Nufw-сервер просто реинжектит пакет из очереди обратно в сетевой стек. В реальности достатчно отправлять на на авторизацию только NEW-пакеты, а остальные будут контролироваться в рамках сединения с помощью conntrack.

Как и в случае с OpenVPN, необходимость установки Nufw-клиента может стать непреодолимым припятствием при использвании устройств с ОС, под которые не существует клиента. В первую очередь это относится к мобильным устройствам.

В 2012 году проект был в "дауне". На начало 2013 похоже проект "восстал из пепла" с новым именем - UFWI

NuFW более громоздок и на момент написания первоначального варианта фаервола не было бесплатного NuFW-клиента под Windows, поэтому в свое время был выбран вариант с PPTP VPN.

Цепочки фильтрации

Теперь рассмотрим непосредственно сами цепочки фильтрации и правила в них. Однако, в отличии от большинства руководств, вместо анализа последовательности команд iptables, мы будем анализировать непосредственно результат их работы, т.е. вывод команды iptables -nvL.

Как видно илз листинга, цепочки имеют "говорящие" имена и пронумерованы. Это позволяет легко ориентироваться в листинге таблицы filter. К тому же цепочки сгруппированы по потокам и всегда выводятся в предсказуемом порядке, что удобно. Рассмотрим эти цепочки.

INPUT, OUTPUT, FORWARD

Листинг начинается со встроенных стандартных цепочек INPUT, OUTPUT, FORWARD. В эти цепочки помещены правила, которые "определяют принадлежность" (по интерфейсам и адресам сетей) пакета к какому-либо логическому потоку и переключают логику дальнейших проверок на последовательность правил в пользовательской цепочке, соответствующей потоку. Пакеты, не соответствующие ни одному из правил в этих цепочках (пакеты не соответствующие ни одному из логических потоков) игнорируются. Достигается это установкой политик по умолчанию (см. Chain XXXX (policy DROP...) Порядок, в котором размещены правила в цепочках INPUT, OUTPUT, FORWARD, косвенно влияет на скорость обработки пакетов: первыми желательно размещать правила, под которые будет, предположительно, подходить основная масса пакетов.Наборы правил, сгруппированые по потокам в пользовательские цепочки, описаны далее в порядке номеров на схеме.

Таким образом, в дальнейшем (после правил в цепочках INPUT, OUTPUT, FORWARD ), пакет проверяется на соответствие только "своим" (относящимся только к данному потоку) правилам, а не всем подряд правилам, имеющимся в firewall'е. Это и даёт преимущества, указанные выше.

Примечание. В англоязычных источниках процесс проверки пакета на соответствие какому-то из правил так и описывается: будто бы пакет "движется" по набору правил, от правилу к правилу, "прыгает" в другие цепочки, "выпрыгивает" из них обратно и т.д. Насколько я понимаю, это условность - в реальности пакет никуда не "движется" (по набору правил), но так очень удобно описывать процесс, в котором ядро, для каждого пакета, перебирает правила, имеющиеся в firewall'e, проверяет, соответствует ли пакет данному правилу и решает что с эти пакетом делать: проверить следующее правило, переключиться (-j ИМЯ_ЦЕПОЧКИ) на другую последовательность (цепочку) правил проверки, принять пакет (-j ACCEPT) или отвергнуть его (-j REJECT/DENY) и т.п. Конечно, взаимосвязь между этапами обработки пакетов в сетевом стеке и таблицами/встроенными цепочками есть, но не более того. Я по тексту буду тоже "грешить" таким подходом, чтобы не ломать язык.

Далее рассмотрим цепочки потоков и наборы правил в них подробнее, ориентируясь по схеме на рис. 3.

Расцветка правил, соответствует цветам потоков на схеме.

01_LAN_GW, 02_GW_LAN: Локальная сеть - шлюз

Начнём со взаимодействия локальной сети LAN и шлюза Gateway. Для цепочки 01_LAN_GW мы "отбираем" только пакеты пришедшие из сети 192.168.0.0/24 на адрес 192.168.0.1 интерфейса eth0, а также пакеты пришедшие из сети 192.168.1.0/24 на адрес 192.168.3.1 любого ppp-интерфейса. Это соответственно правила №2 и №3 в цепочке INPUT. 192.168.3.1 - это адрес серверных концов всех ppp-туннелей, он одинаков для всех и устанавливается в /etc/pptpd.conf.Для цепочки 02_GW_LAN всё наоборот: пакеты уходящие с 192.168.0.1 eth0 в сеть 192.168.0.0/24 и пакеты уходящие со 192.168.3.1 любого ppp-интерфейса в сеть 192.168.1.0/24. Это и есть потоки между локальной сетью и шлюзом.

Примечание. Возможно, вам покажется, излишним указывать в правилах одновременно интерфейс и его адрес (или адрес сети), но это не так. Дело в том, что на любой интерфейс может прийти пакет с абсолютно любым адресом назначения (и отправителя тоже). Если вы укажите только имя интерфейса и не укажете IP-адрес(а), то даже пакет с адресом получателя, не совпадающим с адресом интерфейса, будет принят на дальнейшую обработку и может "проскочить" ваш firewall. Поэтому ни в коем случае нельзя полагаться на то что, раз у вас внутренняя сеть имеет адрес 192.168.0.0/24, то в ней не могут появиться пакеты с адресами принадлежащими другим IP-сетям. Такие ситуации могут возникнуть как в результате попыток обойти firewall так и в штатных режимах, например при маршрутизации (policy routing) или использовании туннелей (IPSec/NETKEY). Тоже самое относится и к отправляемым пакетам: например eth1 имеет адрес 198.51.100.2 но это не значит, что все пакеты отсылаемые провайдеру ISP1 через этот интерфейс обязательно будут иметь адрес отправителя 198.51.100.2. И уж тем более это очевидно в случае, когда интерфейс имеет несколько IP-адресов (да, интерфейс может иметь несолько IP-адресов одновременно).

Итак мы рассмотрели, какие пакеты попадают на проверку в цепочки 01_LAN_GW, 02_GW_LAN. Теперь посмотрим, что у нас в цепочке 01_LAN_GW. Первым же правилом мы отправляем пакет в цепочку со счетчиками 01_LAN_GW_CNT, в которой просто перечислены интересующие нас правила с пустым target (в соответствующенй команде нет ключа -j). Это правило идет самым первым, потому что иначе не будут считаться пакеты уже установленных соединений.

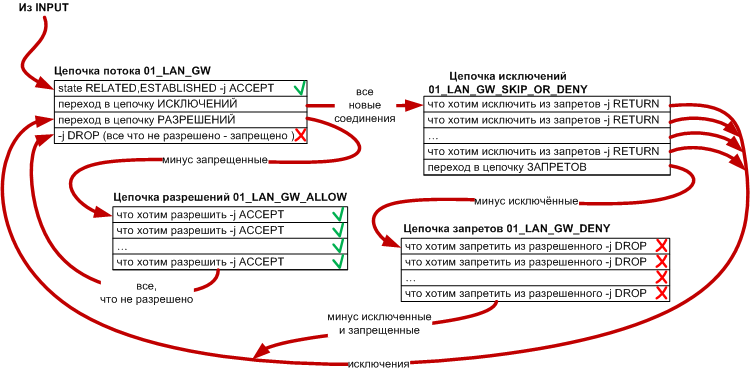

В 01_LAN_GW_CNT, у подходящих правил, счетчики увеличиваются на размер пакета и мы снова возвращаемся в 01_LAN_GW на второе правило. Все "счетчики" являются необязательными и если они вам не нужны - просты выкиньте соответствующие правила и цепочки. Вторым правилом мы принимаем все пакеты, относящиеся к уже установленным соединениям (т.е. те о которых уже "знает" conntrack). Это правило идет вторым и перед правилами, разрешающими подключения на определенные порты, потому что основная масса пакетов будет относиться к уже установленным соединениям. И поэтому нет смысла пакеты "прогонять" сначала через кучу правил для новых соединений и только потом ставить правило RELATED,ESTABLISHED. Следующее правило перекидывает нас в цепочку 01_LAN_GW_SKIP_OR_DENY, в которой мы помещаем правила, запрещающие прохождение каких-либо пакетов и правила, позволяющие сделать исключения из этих запретов. Такая комбинация практически универсальна и позволяет реализовать большинство вариантов запретов и исключений. Остановимся на этом моменте подробнее.

Рассмотрим пример, правда несколько искусственный. Итак, вам надо открыть доступ к порту tcp 873 для всей сети 192.168.0.0/24, за исключением хостов с адресами из диапазона 192.168.0.10-192.168.0.20, но некий узел 192.168.0.13, из этого запрещенного диапазона, тоже должен иметь доступ на tcp 873.

Ясно, что запрещающее правило (192.168.0.10-192.168.0.20 tcp dport 873 DROP) должно идти перед

разрешающим (192.168.0.0/24 tcp 873 tcp dport 873 ACCEPT). А теперь, как из запретного

диапазона исключить 192.168.0.13 tcp dport 873? Надо поставить это правило перед правилом

192.168.0.10-192.168.0.20 tcp dport 873 DROP. А если у нас будет много разных

запрещающих условий и исключений из них? Надо будет следить за порядком следования

этих правил и это будет слишком громоздко.

Поэтому удобнее разнести запрещающие и исключающие правила в разные цепочки

по нижеизложенному принципу.

Как мы уже видели, в основной цепочке потока 01_LAN_GW первым же делом мы принимаем (ACCEPT) все пакеты, относящиеся к уже установленным (RELATED,ESTABLISHED) соединениям. Таким образом, после этого правила, все проверки будут проводиться только над пакетами "в состоянии NEW" (ну еще может быть INVALID), что, по идее, экономит ресурсы. Поэтому далее идет "работа" только с "NEW-пакетами".

Далее проверка из 01_LAN_GW переходит в цепочку 01_LAN_GW_SKIP_OR_DENY, где первыми размещены все исключающие правила с target -j RETURN, а самым последним стоит правило направляющее проверку в список запрещающих правил 01_LAN_GW_DENY. Таким образом пакеты, подпадающие под исключения из запретов, "выскочат сухими" из 01_LAN_GW_SKIP_OR_DENY обратно в 01_LAN_GW, так и не дойдя до цепочки 01_LAN_GW_DENY. А пакеты, не соответствующие исключениям, уйдут на проверку в 01_LAN_GW_DENY и, возможно там и "умрут" (DROP). "Выжившие" (не подошедшие ни под один DROP) "выскочат" сначала в 01_LAN_GW_SKIP_OR_DENY, так как цепочка 01_LAN_GW_DENY закончилась, а затем и в 01_LAN_GW. И если эти пакеты не будут соответствовать разрешающим правилам (ля-ля-ля state NEW -j ACCEPT) в этой цепочке, они будут "убиты" самым последним правилом в цепочке 01_LAN_GW (DROP), которое, в некторой степени, является перестраховочным, но полезным. Оно скорейшим образом убъет "неугодный" пакет, не давая ему "выпрыгнуть" обратно в INPUT и "гулять" по остальным правилам пока его не DROP'нут по default'у.

Таким образом, достаточно универсальную логику для одного потока можно построить по следующей схеме:

Т.е. разрешающие правила располагаются после всех запрещающе-исключающих правил.

Да, конечно можно, вместо использования цепочек LAN_GW_DENY и LAN_GW_ALLOW, просто выстроить правила в нужном порядке: сначала RELATED/ESTABLISHED, затем все запрещающие и затем все разрешающие - эффект будет (почти) тот же. "Почти" потому что, теряется возможность вносить исключения в запреты посредством добавления правил в LAN_GW_SKIP_OR_DENY - без использования цепочки подобный "пропуск" группы правил невозможен. Также теряется простой (путем очистки соответствующей цепочки) способ обновить часть правил: только разрешающие или только запрещающие. Т.е. возможности оптимизации зависят от наличия или отсутствия тех или иных правил в конкретном потоке. Эту задачу можно решить с помощью скриптов.

Назначение большей части открытых портов в 01_LAN_GW думаю очевидна. Специально поясню только два правила:

- tcp dpt:1723 - разрешаем подключения к демону pptp, так как контроль доступа из внутренних во внешние сети построен на использовании PPTP-туннелей

- proto 47 - он же GRE, в него упаковываются ppp-пакеты PPTP-туннелей, поэтому нам тоже его нужно разрешить; протокол GRE что называется stateless, поэтому нет особого смысла указывать state NEW. Здесь он указан, потому что правила созданы автоматически скриптом.

Теперь о цепочке 02_GW_LAN. Здесь мы описываем, что сам шлюз может посылать в сеть LAN. Здесь все тоже построено по вышеописанному принципу. Так же, вторым правилом после счетчиков, идет ... state RELATED,ESTABLISHED...ACCEPT, для того чтобы принимать пакеты ранее установленных соединенений.

Порты в 02_GW_LAN.

- tcp spt:5222, tcp spt:5223 - протокол XMPP; в сети LAN есть Jabber-сервер, на него шлюз отсылает некую информацию (оповещения от разных скриптов) со шлюза, которая оперативно видна в IM-клиенте

- tcp spt:20 - на шлюзе есть ftp-сервер (для технических целей), подключение к нему идет в active-режиме через SSL, поэтому модуль ядра ip_conntrack_ftp не сможет распознать в зашифрованном потоке служебную информацию FTP-протокола и отнести новое соединение, которое сервер пытается установить с клиентом, к состоянию RELATED; таким образом правило ACCEPT ... state RELATED,ESTABLISHED для таких соединений срабатывать не будет и выход только один: явно разрешить ftp-серверу подключаться c tcp порта 20 шлюза на любой адрес и порт сети LAN; см. схему для Active FTP, например здесь Active FTP vs. Passive FTP, a Definitive Explanation

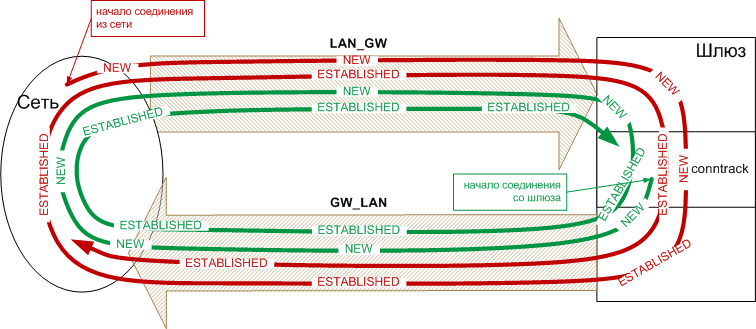

Почему RELATED,ESTABLISHED нужен в обоих направлениях

Помню, когда я начинал писать свои первые правила фаервола, я не до конца понимал, почему RELATED,ESTABLISHED нужен в обоих направлениях, даже если я разрешаю соединения только в одну сторону.

Чтобы лучше понять, почему, я рисовал диаграмки на бумажках, а здесь привожу следующую диаграмму. Думаю, с ней всё станет очевидно.

03_INET_GW, 04_GW_INET: Интернет - шлюз

Это потоки между самим шлюзом и сетью Интернет. Как видно из схемы, существует два пути для трафика между шлюзом и Интернетом: через провайдера ISP1 и через провайдера ISP2. Соответственно для проверок, в эту цепочку отбираются следующие пакеты (смотрим цепочки INPUT, OUTPUT):-

для пути через провайдера ISP1

- входящие на адрес 198.51.100.2 интерфейса eth1

- выходящие из интерфейса eth1 с адресом источника 198.51.100.2

- входящие на адрес 192.168.5.1 интерфейса eth3 не из сети 192.168.0.0/16 (в том числе не из сети 192.168.5.0/24)

- выходящие из интерфейса eth3 с адресом источника 192.168.5.1 не в сеть 192.168.0.0/16

Выданный провайдером ISP1, адрес 198.51.100.2 на eth1, является статическим, поэтому внешние сервисы (ftp/smtp/dns/pop3) "слушают" на этом адресе и интерфейсе. Именно этот адрес является "адресом шлюза в сети Интернет". А вот адрес 192.168.5.1 на интерфейсе eth3 является внутренним, а внешний адрес присваивается внешнему интерфейсу модема ADSL №2 динамически. Т.е. шлюз своим интерфейсом eth3 непосредственно в Интернете "не виден". Поэтому организовать на нем внешние сервисы возможно, но на практике это связано с различными проблемами, связанными как с динамическим адресом модема (обновление DNS, RR в обратной зоне для SMTP-сервера и т.п.), так и необходимостью использования DNAT на модеме для осуществления проброса портов (port forwarding) от модема на eth3 шлюза. Т.о., в нашем примере, для интерфейса eth1 надо открыть порты внешних сервисов, а вот для eth3 это делать не надо.

Поэтому, специально для трафика, приходящего из Интернета на eth3 сделана отдельная цепочка 03_INET_GW_ISP2, которая фактичеcки является копией 03_INET_GW, но без "NEW-правил". В ней мы только считаем и разрешаем трафик от уже установленных соединений.

Почему в INPUT в правиле для 03_INET_GW_ISP2 мы не указали destination 192.168.5.1? Это связано с тем опять же с маршрутизацией через двух провайдеров: на интерфейс eth3 могут приходить и пакеты с адресом назначения 198.51.100.2, а не только 192.168.5.1. Причины этого рассмотрены в разделе "Этапы прохождения пакета через NETFILTER"

Схема же построения правил в цепочках 03_INET_GW, 04_GW_INET совпадает со схемой правил в цепочках 01_LAN_GW, 02_GW_LAN и не имеет каких-то отличительных особенностей.

05_LAN_INET, 06_INET_LAN: Локальная сеть - Интернет

Переходим к рассмотрению несколько более интересной ситуации: трафик между локальной сетью LAN и сетью Интернет. Здесь также два пути прохода трафика: через провайдера ISP1 и провайдера ISP2.В данном примере цепочки 05_LAN_INET, 06_INET_LAN универсальны и служат для фильтрации по обоим маршрутам, т.е. правила фильтрации одни и те же для трафика через обоих провайдеров.

Эти цепочки используются для проверки следующих пакетов (смотрим схему и правила):

-

для трафика через провайдера ISP1:

- входящих из сети 192.168.0.0/24 в интерфейс eth0 и выходящих через eth1;

- входящих из сети 192.168.1.0/24 в любой ppp-интерфейс и выходящих также через eth1 (для хостов, получающих доступ в Интернет через ppp-соединение);

- входящих из сети 192.168.0.0/24 в интерфейс eth0 и выходящих через eth3 на адреса не из сети 192.168.0.0/16. Дополнительный контроль целевой сети нужен для того, чтобы отличить трафик идущий конкретно в сеть 192.168.5.0/24 (т.е. LAN->LAN2) от любого другого (подразумевается, что для локальных сетей выбраны адреса из диапазона 192.168.0.0/16)

- входящих из сети 192.168.1.0/24 в любой ppp-интерфейс и выходящих через eth3 на адреса не из сети 192.168.0.0/16 (принцип тот же).

Смотрим как устроена цепочка 05_LAN_INET. Принцип тот же, что и в цепочках, рассмотренных выше. Но есть некоторые отличия.

Первое отличие - наличие цепочки 05_LAN_INET_LIMIT. Если в цепочках "сеть-шлюз" органичение на скорость создания новых подключений ограничивалась непосредственно в разрешающем правиле, то здесь удобно иметь глобальные (на всю сеть LAN) ограничения. Поясню как это работает. Но сначало о том, что привело к появлению цепочки 05_LAN_INET_LIMIT.

Если в сети LAN появятся зараженные компьютеры, то с высокой вероятностью они станут рассылать спам и прочую ерунду посредством SMTP-протокола, напрямую подключаясь к различным SMTP-серверам в Интернете. Не полагайтесь на наличие антивируса: всегда найдется машина, не защищенная в данный момент антивирусом (сотрудник или клиент принес свой ноутбук) либо найдется вирус, который не дететктируется установленным антивирусом. 100%-ый выход один - заблокировать подключение на tcp 25 на сетевом уровне. Однако при этом пользователи сети теряют возможность отправлять почту через внешние SMTP-сервера посредством почтовых агентов. Если это не проблема для сотрудников и/или у вас в сети есть свой собственный SMTP-сервер (естественно с SMTP-аутентификацией для защиты от неавторизованной рассылки), то можно решить эту проблему и так. А можно поступить чуть менее жестко.

Можно вместо жесткого запрета, сделать исключения для некоторых, нужных вам серверов, например популярных почтовых сервисов. Как раз правила в 05_LAN_INET_SKIP_OR_DENY и разрешают доступ к 25 tcp портам некоторых почтовых сервисов. А в 05_LAN_INET_DENY есть запрещающее правило на dst tcp 25. Таким образом мы запрещаем подключения на 25 tcp порт всех хостов в Интернете за исключением перечисленных в 05_LAN_INET_SKIP_OR_DENY.

Второй вариант - лимитировать кол-во подключений на 25 tcp в единицу времени. Так как задача вируса или бота - разослать как можно быстрее и больше, то можно заблокировать слишком часто идущие попытки подключения на 25 tcp. Правда это подразумевает, что бот остылает одно (или мало) сообщений через одно подключение (SMTP-сессию).

Для этого можно воспользоваться модулями iptables limit, hashlimit или recent.

В нашем примере использован limit - разберем сначала его. В 05_LAN_INET_LIMIT первое правило говорит: "Разрешить новые подключения на tcp порт 25 не чаще 2-х раз в минуту для каждой комбинации "адрес источника-адрес приемника" и допускается "сжечь"(использовать) до пяти подключений без контроля (промежутка времени)".

Перескажу своими словами, как работает этот алгоритм:

в некий "счетчик" ("корзину" - bucket) емкостью (burst) 5, с постоянной частотой 2 раза

в минуту "капают" (поступают) разрешения ("билеты") на прохождение пакета (т.е. чтобы "корзина"

заполнилась "до краев" надо около 2,5 минут). После заполнения "до верху" разрешения уже не капают,

а ждут пока в "корзине" появится свободное место. Свободное место появляется при

выдаче разрешения на прохождение одного пакета: одно разрешение - один пакет.

Теперь, пусть клиент из сети пытается подключиться к 25-му порту 10 раз в течении 10 секунд

(отправить 10 "NEW-пакетов" за 10 секунд).

Произойдет следующее: накопившиеся в корзине 5 разрешений будут "мгновенно" использованы

и 5 подключений будут сделаны в кратчайшие сроки и корзина опустошится: разрешениий

на прохождение пакетов больше нет. Теперь оставшиеся 5 пакетов смогут уйти,

только если в корзине появятся разрешения для них (по одному на пакет): поэтому

клиенту для отправки следующего (6-го) пакета придется ждать пока в корзину "капнет" очередное разрешение.

А так как капают они по 2 в минуту, то чаще двух подключений в минуту

клиент уже сделать не сможет. Если он снизит частоту своих подключений ниже 2/мин,

то разрешения снова смогут накапливаться до 5 (емкости корзины).

http://en.wikipedia.org/wiki/Token_bucket

Подключения, идущие чаще 2/минуту, не будут разрешены первым правилом и проверка "проваливается" дальше: на второе и третье правила. Ну а третье правило просто "убивает" пакет, который бы привысил заданную частоту. А вот второе правило записывает в системный лог (и возможно выдает на консоль) сообщение, но тоже с частотой не превышающей определенной заданной. Дело в том что, если пакеты, не подпадающие под лимит будут идти с большой частотой, то в лог (и на консоль!) будут, с этой же частотой, добавляться записи о каждом пакете (а их может быть ОЧЕНЬ много). Для ограничения записи в лог используется тот же модуль limit. Т.е. в логе мы увидим запись не о каждом пакет, превысившим частоту предыдущего правила, а только о части, не превысившей ограничений команды ...-j LOG Таким образом мы можем ограничить частоту подключений до желаемой величины, практически не даваю боту из сети забивать ваш канал и "сильно беспокоить" SMTP-сервера. Однако соединения хоть и редко, но будут осуществляться. Вообще этот модуль служит для защиты от DOS-атак, когда не надо полностью блокировать доступ.

Можно применить оба похода одновременно, что и видно на примере: ограничены сервера, на которые можно пдключаться и частота, с которой к ним можно подключаться.

Вместо модуля limit можно использовать использовать модуль recent. Для этого вместо трех команд, приведенных в примере, можно использовать такие:

iptables -A 05_LAN_INET_LIMIT -p tcp --dport 25 -m recent --update --seconds 120 --hitcount 5 --name LAN_INET_25 --rdest \ -m limit --limit 1/min --limit-burst 5 -j LOG --log-prefix `LAN->INET_SMTP_limit: ' iptables -A 05_LAN_INET_LIMIT -p tcp --dport 25 -m recent --update --seconds 120 --hitcount 5 --name LAN_INET_25 --rdest -j DROP iptables -A 05_LAN_INET_LIMIT -p tcp --dport 25 -m recent --set --name LAN_INET_25 --rsource -j ACCEPTчто даст нам следующее

0 0 LOG tcp -- * * 0.0.0.0/0 0.0.0.0/0 tcp dpt:25 recent: UPDATE seconds: 120 hit_count: 5 name: LAN_INET_25_LOG side: dest limit: avg 6/hour burst 5 LOG flags 0 level 4 prefix `LAN->INET_SMTP_limit: ' 0 0 DROP tcp -- * * 0.0.0.0/0 0.0.0.0/0 tcp dpt:25 recent: UPDATE seconds: 120 hit_count: 5 name: LAN_INET_25 side: dest 0 0 ACCEPT tcp -- * * 0.0.0.0/0 0.0.0.0/0 tcp dpt:25 recent: SET name: LAN_INET_25 side: sourceи означает: "если с определённого адреса за 120 секунд или менее будет происходить более 5 попыток подключения" - "убивать" пакеты с этого адреса в дальнейшем до тех пор, пока частота не снизится до "не более 5-ти пакетов за 120 секунд". Это условие описывается двумя правилами, а не одним (подробнее читайте документацию recent)

Какой эфект даст recent в сравнении с limit? После момента превышения частоты и до её спада ниже заданного уровня recent полность болкирует трафик, а limit "цедит в час по чайной ложке" как указано в параметре --limit. Но в limit можно указать отслеживание лимита по комбинации "источник-приёмник", а у recent либо только "источник", либо только "примёник": c limit можно ограничить каждую пару IP (source-destination) в отдельности, а с recent - только всю сеть, как единое целое.

07_INET_DMZ, 08_DMZ_INET: Интернет - DMZ

Как уже говорилось ранее сеть DMZ предназначена для размещения внешних сервисов. В нашем примере часть сервисов расположена на самом шлюзе (хотя это и является плохой практикой!), а в DMZ расположены два web-сервера: один с адресом 203.0.113.2 и другой с адресом 203.0.113.3. Предполагается, что доступ к серверам в DMZ извне осуществляется только через провайдера ISP1 по внешнему адресу 198.51.100.2, по причинам, описанным в разделе Интернет - шлюз. Рассмотрим соответствующие цепочки.Ситуация похожа на рассмотренную "трафик между двумя сетями, идущий через шлюз". Смотрим на схему и листинг цепочек и видим, что для этих цепочек мы отбираем следующие пакеты.

-

Для пути через провайдера ISP1:

- входящие в интерфейс eth1 и выходящие через eth2 с адресом сети назначения 203.0.113.0/29;

- входящие из сети 203.0.113.0/29 на интерфейс eth2 и выходящие через eth1.

- входящие в интерфейс eth3 и выходящие через eth2 с адресом сети назначения 203.0.113.0/29;

- входящие из сети 203.0.113.0/29 на интерфейс eth2 и выходящие через eth3.

Принцип построения цепочек такой же как и в остальных. Особо можно отметить, что здесь контролируются не только входящие порты (т.е. на какие порты можно подключиться извне), но и исходящие порты: куда и на какие порты в Интернете могут подключаться сервера из DMZ.

Так же как и в цепочках сединения Интернет - шлюз, для входящих на eth3 через ISP2 пакетов создана специальная цепочка 07_INET_DMZ_ISP2, в которой нет разрешений для установления новых соединений из сети Интернет.

09_LAN_DMZ, 10_DMZ_LAN: Локальная сеть - DMZ

Основная особенность у этих цепочек - однонаправленность для новых соединений: хосты из сети LAN должны иметь возможность подключаться (устанавливать новые соединения) к хостам сети DMZ, а вот наборот: хосты из сети DMZ к хостам сети LAN - нет.Для этих цепочек мы отбираем пакеты:

- входящие в интерфейс eth0 из сети 192.168.0.0/24 и выходящие через eth2 с адресом сети назначения 203.0.113.0/29

- входящие из сети 192.168.1.0/24 на любой ppp-интерфейс и выходящие через eth2 с адресом сети назначения 203.0.113.0/29

Второй момент, на который можно обратить внимания - правила, где есть tcp spts:60000:61000.

Они связаны с протоколом FTP через SSL

(как и tcp spt:20 разделе Локальная сеть - шлюз).

Только приём с открытием 20 порта здесь "не пройдет" из-за active mode протокола FTP!

Ведь в этом случае мы будем вынуждены разрешить подключения из DMZ в LAN,

чего мы крайне не хотим!

Выход один - использовать пассивный режим (passive mode) в котором все соединения инициирует только клиент (см. Active FTP vs. Passive FTP, a Definitive Explanation). Для этого на серверах в DMZ надо сконфигурировать ftp-сервер на прослушивание фиксированного диапазона портов, на которые клиент будет подключаться для передачи данных. Вот как раз прохождение пакетов на этот диапазон портов и нужно будет разрешить на шлюзе в потоках LAN->DMZ.

Фильтрация и отслеживание соединений (connection tracking)

В рассматриваемом варианте организации правил используются возможности NETFILTER по отслеживанию состояния соединений (stateful packet inspection), что необходимо учитывать в ситуциях, подобной описанной ниже.

Пусть для некоего хоста в данный момент разрешено прохождение пакетов: установление новых соединений разрешают правила типа -m state NEW, а прохождение остальных пакетов этих соединений разрешаются правилами типа -m state RELATED, ESTABLISHED. Пусть, начиная с какого-то момента исчезает необходимость в разрешении трафика данному хосту: для него планируется полностью удалить все правила (удалить хост из конфигурации), а не просто запретить трафик, явно добавив запрещающие правила. При этом подразумевается, что после удаления всех, в т.ч. разрешающих, правил, обмен пакетами для данного хоста тут же станет невозможным.

Однако только удаления рарзрешающих правил в такой ситуации недостаточно. Т.к. остаются правила типа -m state RELATED, ESTABLISHED, то хост сможет получать/отправлять пакеты в рамках ранее установленных соединений до момента их разрыва: явного или по таймауту. Например, если в момент удаления из конфигурации хост загружал некий файл, то и после удаления правил хост сможет продолжать загружать данный файл, пока он полностью не будет загружен.

Чтобы одновременно с удалением правил для хоста из конфигурации сразу же блокировался и весь связанный с хостом трафик, необходимо либо явно удалить все соединения данного хоста из таблицы connection tracking, либо перед удалением хоста из конфигурации предварительно ввести для него запрещающие правила и дождаться разрыва всех соединений по таймауту и только потом удалять все правила.

Для удаления отслеживаемых соединений а также других манипуляций с соединениями необходима утилита conntrack из пакета conntrack-tools.

Для работы утилиты conntrack необходимо предварительно загрузить модуль ядра ip_conntrack.

modprobe ip_conntrack # загружаем модуль ядраИ далее, например, чтобы удалить все соединения, установленные хостом с адресом 192.168.1.3 надо выполнить команду:

conntrack -D -s 192.168.1.3По этой же причине, для того чтобы запрещающие правила действовали и на уже установленные соединения, их необходимо вводить перед RELATED, ESTABLISHED-правилами. См. цепочку 05_LAN_INET в листинге таблицы filter.

Если же вам достаточно запрета только новых соединений, то запрещающие правила оптимальней вводить после RELATED, ESTABLISHED для уменьшения кол-ва правил, по которым проверяется каждый пакет данного потока.

Маршрутизация (routing)

Маршрутизация - процесс в котором определяется путь, по которому пойдет трафик. Поэтому для любого исходящего трафика должен быть каким-то образом определен (задан) маршрут, каким он пойдет до цели.

Маршрутизацию осуществляет ядро Linux. Настраивается же маршрутизация командой ip из пакета iproute или коммандой route из пакета net-tools. route не позволяет управлять всеми аспектами маршрутизации в Linux и является, в принципе, устаревшей. Поэтому рассматривается управление только через команду ip.

Стоит отметить, что в примере рассмотрена только статическая маршрутизация (static routing), при которой автоматически не отслеживаются изменения топологии (связей между хостами) сети, и таблицы маршрутизации не изменяются автоматически в ответ на изменение топологии.

Один провайдер

Сначала, рассмотрим как происходит маршрутизация, без учета того факта, что в Интернет можно "попасть" и через ISP2 (eth3). Рассмотрим таблицу маршрутизации для нашего примера:

#ip route show 192.168.1.1 dev ppp1 proto kernel scope link src 192.168.3.1. 192.168.1.3 dev ppp2 proto kernel scope link src 192.168.3.1. 192.168.255.2 dev tun1 proto kernel scope link src 192.168.255.1. 198.51.100.0/30 dev eth1 proto kernel scope link src 198.51.100.2. 203.0.113.0/29 dev eth2 proto kernel scope link src 203.0.113.1. 192.168.5.0/24 dev eth3 proto kernel scope link src 192.168.5.1. 192.168.0.0/24 dev eth0 proto kernel scope link src 192.168.0.1. 192.168.255.0/24 via 192.168.255.2 dev tun1. default via 198.51.100.1 dev eth1.

Пройдемся по таблице. Тут все просто - адрес назначения пакета ищется в этой таблице: если адрес назначения в пакете совпал с адресом в таблице (в случае сети - если принадлежит данной сети), то пакет направляется через интерфейс, указанный в подходящей строке. Двух одинаковых адресов (хостов или сетей) в этой таблице быть не может, поэтому и двух путей (через разные интерфейсы) к одному хосту (или в одну сеть) здесь задать нельзя.

192.168.0.0/16

192.168.5.0/24

то адрес 192.168.5.1 соответствует обоим сетям, но выбран будет маршрут для 192.168.5.0/24 так как здесь префикс (сети) длиннее.

Итак, первые два маршрута в таблице говорят о том, что пакеты для хоста с адресом

192.168.1.1 надо доставлять через интерфейс ppp1, а для хоста 192.168.1.3 -

через ppp2.

Это PPTP-клиенты подключившиеся из сети LAN.

3-ий маршрут говорит что пакеты для хоста с адресом

192.168.255.2 надо доставлять через через интерфейс tun1.

Это виртуальный интерфейс сервера OpenVPN.

4-ый маршрут говорит что пакеты для сети с адресом

198.51.100.0/30 надо доставлять через интерфейс eth1.

Это glue-сеть между шлюзом и щлюзом провайдера с адресом 198.51.100.1.

5-ый маршрут говорит что пакеты для сети с адресом

198.51.100.0/30 надо доставлять через интерфейс eth2.

Это сеть DMZ, 203.0.113.1 - адрес интерфеса eth2 в этой сети.

6-ой маршрут говорит что пакеты для сети с адресом

192.168.5.0/24 надо доставлять через интерфейс eth3.

Это сеть LAN2, 192.168.5.1 - адрес интерфеса eth3 в этой сети.

7-ой маршрут говорит что пакеты для сети с адресом

192.168.0.0/24 надо доставлять через интерфейс eth1.

Это сеть LAN, 192.168.0.1 - адрес интерфеса eth1 в этой сети.

8-ой маршрут говорит что пакеты для сети с адресом 192.168.255.0/24 надо доставлять через шлюз (в сеть OpenVPN) 192.168.255.2 через интерфейс tun1.

И наконец 9-ый маршрут говорит что пакеты для которых не было найдено

подходящго маршрута (т.е. хоста/сети назначения)

доставлять через через интерфейс eth1 на шлюз ("via" - "через") 198.51.100.1.

Это шлюз провайдера ISP1, через который пакеты далее попадут в Интернет.

Это и есть маршрут "по-умолчанию" (default).

Собственно так пакеты, "предназначенные для Интернета", и "попадают в Интернет". Это просто пакеты, для которых ядро не знает, где расположена нужная сеть/нужный узел (потому что не все сети в мире подключены непосредственно к вашему шлюзу), и поэтому ему ничего не остается как направить их туда, "где находятся все остальные сети".

Все эти маршруты были добавлены в таблицу маршрутизации автоматически при инициализации интерфейсов на основании конфигурационной информации. В Debian это файл /etc/network/interfaces.

Поэтому, в случае одного провайдера вручную делать особо ничего и не надо, кроме как правильно сконфигурировать интерфейсы. При указанной выше конфигурации таблицы маршрутизации весь "Интернет-трафик" идет только через провайдера ISP1.

Два провайдера

В этом случае возникает несколько вариантов того какой именно трафик куда и когда направить:

- направить все исходящие соединения через одного определённого провайдера;

- направить исходящие соединения через двух провайдеров: часть соединений через одного провайдера, оставшуюся часть - через другого, согласно неким критериям;

- приём всех входящих соединений только через одного провайдера

- приём входящих соединений через двух провайдеров одновременно, используя разные публичные адреса

Например, самый простой случай - это использовать ISP1 и ISP2 попеременно, переключаясь между ними по необходимости. Для этого самое простое - менять в таблице маршрутизации маршрут по умолчанию с

default via 198.51.100.1 dev eth1на

default via 192.168.5.10 dev eth3где 192.168.5.10 адрес модема ADSL модем №2 в сети LAN2, который выполняет роль шлюза в сеть провадера ISP2 и далее в Интернет.

А что делать если мы хотим использовать оба канала одновременно?

Использовать то, что называется "policy routing" (марщрутизация по политикам) совместно с несколькими таблицами маршрутизации (множественные таблицы маршрутизации).

Policy routing

Policy routing - механизм позволяющий управлять маршрутизацией не только на основании адреса-назначения в пакете (как только что было показано выше), но и на основе других критериев.

Взглянем на всю картину в целом. В действительности, та таблица маршрутизации, которая была показана выше является всего лишь одной из существующих таблиц маршрутизации и называется она main. Есть еще две "встроенные" таблицы: local и default. И, к тому же, можно создавать дополнительные таблицы маршрутизации - до 252 таблиц. Итак можно создать несколько таблиц с разными наборами маршрутов. А вот для того чтобы, управлять, тем по какой из этих таблиц будет определятся маршрут для того или иного пакета и нужна routing policy database (RPDB) (база политик маршрутизации). Используя только команду route невозможно управлять всем этим механизмом - она позволяет манипулировать только маршрутами в одной определенной таблице - main. Для полноценного управления мрашрутизацией служит команда ip из пакета iproute2

RPDB имеет несколько вариантов селекторов (selector) и действий (action), которые позволяют нам указать ядру: вот c такими пакетами делай указанное действие. Например: пакеты, идущие с такого-то адреса маршрутизируй (т.е. определяй куда его послать) с использование вот этой таблицы или пакеты помеченные так-то - блокируй и т.д. Селекторы можно комбинировать. Ниже приведен пример RPDB:

#ip rule show 0: from all lookup local 32763: from all fwmark 0x4 lookup isp2 32766: from all lookup main 32767: from all lookup default

Номер до двоеточия - приоритет записи в базе , все что до слова "lookup" - селектор(ы) и последнее - имя таблицы маршрутизации. Например запись 32763 значит: для пакетов с любым ("from all") адресом источника и у которых отметка MARK равна 0x4 (просто число, которым мы помечаем определенные пакеты в NETFILTER), маршрут определять по таблице с именем "isp2". Т.е. в этой записи скомбинированы два селектора: "from" и "fwmark".

- записи (правила) в RPDB перебираются в порядке их приоритета (первое число в записи RPDB)

- если данный пакет соответствует селектору правила, то выполняется действие указанное в правиле

- если указанное в правиле действие окончательно определяет маршрут пакета, то правила, следующие за "сработавшим" перебираться для данного пакета уже не будут, иначе перебор правил продолжается

Например: если в правиле указана некая таблица маршрутизации, то производится поиск подходящего маршрута в этой таблице: если маршрут найден, то правила RPDB, следующие за "сработавшим" перебираться для данного пакета не будут (так как маршрут определен), а вот если в таблице маршрутизации не будет найдено ни одного подходящего маршрута, то перебор правил в RPDB будет продолжен.

Например если в базу, показанную выше, добавить такое правило#ip rule del from all fwmark 0x4 priority 32700 prohibitто мы получим вот такую таблицу

#ip rule show 0: from all lookup local 32700: from all fwmark 0x4 prohibit 32763: from all fwmark 0x4 lookup isp2 32766: from all lookup main 32767: from all lookup default

В ней для пакетов с одной и той же отметкой MARK сначала идет правило с запретом (prohibit), поэтому все пакеты, имеющие отметку MARK=0x4 будут запрещены. Для таких пакетов правило с приоритетом 32763 уже никогда срабатывать не будет, так как в правиле 32700 маршрут пакета однозначно будет определен (запрет) в процессе маршрутизации!

Или другой пример. Например если в базу добавить такое правило с таблице маршрутизации:#ip rule add from all fwmark 0x4 priority 32700 table newtableто мы получим вот такую таблицу

#ip rule show 0: from all lookup local 32700: from all fwmark 0x4 lookup newtable 32763: from all fwmark 0x4 lookup isp2 32766: from all lookup main 32767: from all lookup default

В этом случае, если в таблице маршрутизации newtable для пакета найдется подходящее правило, то правило с приоритетом 32763 тоже не сработает. А вот если в таблице newtable не найдется ни одного подходящего для данного пакета правила маршрутизации, то пакет далее будет проверяться на правило с приоритетом 32763.

Видов селекторов не так уж много (смотрите документацию), но один из них "убойный" - это fwmark.

fwmark: NETFILTER+routing

Селектор fwmark позволяет сделать одну, но очень мощную вещь: отбирать в правилах RPDB пакеты на основе меток, которые можно с помощью NETFILTER ставить в пакетах.

С помощью iptables мы можем "помечать" пакеты в таблице mangle. Тут важно знать что эти метки вставляются не внутрь пакета, а ассоциируются с пакетом, до тех пор пока пакет не ушел в сеть. Т.е. эти метки привязаны к пакету, но хранятся вне его - в памяти ОС и по сети не передаются. Метки существуют пока пакет "крутится" внутри операционной системы данного хоста (компьютера).

Еще важно помнить про разные типы меток, которые могут быть привязан к пакету одновременно и которые не надо путать между собой (CONNMARK, CONNSECMARK, MARK, SECMARK). Также важно не путать установку отметки (это определённые виды target'ов в ключе '-j') c проверкой на соответствие (match) между отметкой в пакете и заданной в правиле. Сейчас речь пойдет о отметках, которые проставляются у пакетов target'ом MARK.

Итак есть все элементы для решения задачи маршрутизации через двух провайдеров:

- возможность создать несколько таблиц маршрутизации

- возможность NETFILTER помечать нужные нам пакеты

- база политик маршрутизации, позволяющая задать правила (в том числе и через отметки в пакетах): какой трафик с помощью какой таблицы маршрутизировать

Теперь уточним, чего именно хотим добиться:

- общий принцип: каким путем трафик пришел (извне), таким и должен уйти и каким путём ушёл (из наших сетей) таким и должен вернуться;

- чтобы весь трафик между сетями LAN, DMZ и сетью Интернет шёл через провайдера ISP2 за исключением:

- rdp трафик (tcp 3389) должен идти через ISP1;

- VPN трафик между мобильными клиентами и сетью LAN должен идти через ISP1. Клиенты будут подключаться только через ISP1 на адрес 198.51.100.2, поэтому и уходить трафик должен через ISP1;

- трафик пользователя "user" (192.168.1.3) шёл через ISP1;

- чтобы весь трафик между шлюзом Gateway и сетью Интернет шёл через провайдера ISP2 за исключением:

- SMTP-сессии (tcp 25) должны идти через ISP1; это связано с тем, что сейчас многие SMTP-сервера проверяют не является ли адрес динамическим, проверяют по обратной зоне DNS, проверяют SPF и т.д. Поэтому, чтобы не иметь проблем с уходом почты с вашего SMTP-сервера, лучше чтобы трафик шёл со статического адреса, с правильно прописанной RR в обратной зоне;

- DNS-трафик (udp, tcp 53) должен идти через ISP1 - трафик критичный (для того же SMTP) и если "отвалится" ADLS модем №2, почта может не уходить из-за недоступности DNS. Поэтому DNS пускаем тем же путем, что и SMTP - через более надёжный канал через ISP1.

После старта ОС у нас уже есть автоматически сконфигурированная основная таблица маршрутизации "main". Она используется как основная для маршрутизации во все сети, подключенные к шлюзу.

#ip route show table main 192.168.1.1 dev ppp1 proto kernel scope link src 192.168.3.1. 192.168.1.3 dev ppp2 proto kernel scope link src 192.168.3.1. 192.168.255.2 dev tun1 proto kernel scope link src 192.168.255.1. 198.51.100.0/30 dev eth1 proto kernel scope link src 198.51.100.2. 203.0.113.0/29 dev eth2 proto kernel scope link src 203.0.113.1. 192.168.5.0/24 dev eth3 proto kernel scope link src 192.168.5.1. 192.168.0.0/24 dev eth0 proto kernel scope link src 192.168.0.1. 192.168.255.0/24 via 192.168.255.2 dev tun1. default via 198.51.100.1 dev eth1.

Теперь подготовим альтернативную таблицу маршрутизации, которую назовем "isp2". У этой таблицы только одна роль - определить другой "маршрут по умолчанию", отличный от того, который указан в таблице маршрутизации "main".

В файле /etc/iproute2/rt_tables описываем новую таблицу# # reserved values # 255 local 254 main 253 default 0 unspec # # local # #1 inr.ruhep 1 isp2 # таблица которую мы добавиливыполняем команды

#ip route flush table isp2 #route add default via 192.168.5.10 dev eth3 table isp2проверяем, что получилось

#ip route show table isp2 default via 192.168.5.7 dev eth3

Добавим новую политику в RPDB

#ip rule add from all fwmark 0x4 table isp2проверяем, что получилось

#ip rule show 0: from all lookup local 32763: from all fwmark 0x4 lookup isp2 32766: from all lookup main 32767: from all lookup default

Осталось сделать один шаг - пометить те пакеты, которые будут маршрутизироваться по таблице "isp2". Для этого надо разобраться с еще одним важным вопросом - где и каким образом помечать нужные пакеты.

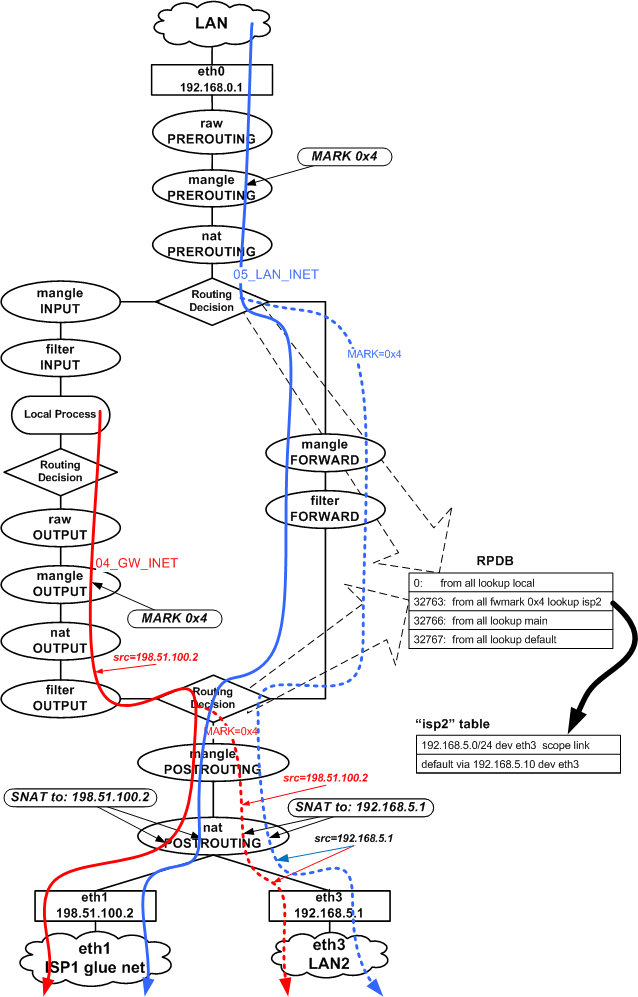

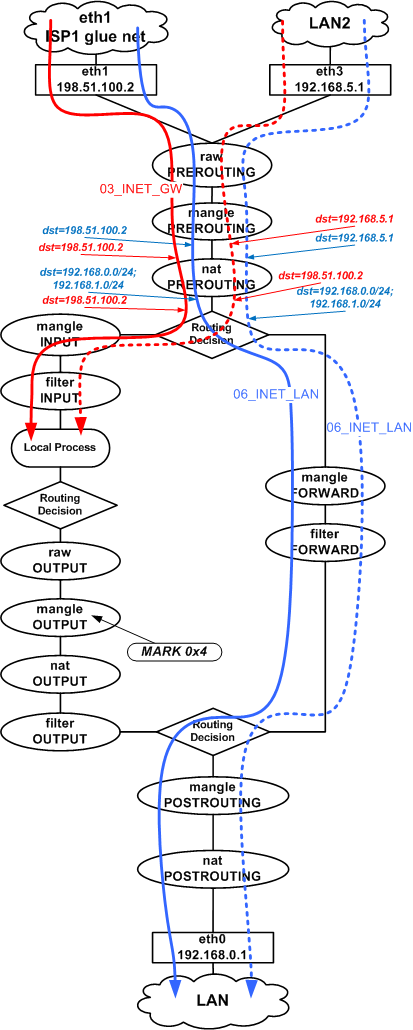

Этапы прохождения пакета через NETFILTER

Открываем листинг команды 'iptables -t mangle -nvL', чтобы было удобнее следить за дальнейшими пояснениями.

Ниже приведена схема этапов (таблицы и цепочки) которые проходит пакет. Информация о этапах взята отсюда: http://www.frozentux.net/iptables-tutorial/iptables-tutorial.html#TRAVERSINGOFTABLES

На схеме показаны таблицы и цепочки, которые проходит трафик, маршрутизируемый с помощью таблиц "main" и "isp2" (пунктирное ответвление), точки в которых осуществляется пометка пакетов (MARK) и преобразование адресов (SNAT).

Поток GW->INET (цепочка 04_GW_INET_MARK в mangle)

Исходя из сказанного, помечаем нужные нам пакеты трафика Gateway<->Internet

в mangle OUTPUT. Почему, например, не в mangle POSTROUTING? Отметку надо проставить

еще до процесса маршрутизации (routing decision), чтобы на момент

осуществления маршрутизации нужные пакеты уже имели нужную метку.

Пометка в mangle POSTROUTING просто не будет иметь никакого эффекта.

Таким образом,согласно правилу from all fwmark 0x4 lookup isp2 в RPDB, трафик c отметкой 0x4, на финальном этапе маршрутизации будет направлен в eth3. По пути будет сделано преобразование адресов (SNAT to:192.168.5.1) и после этого трафик через eth3 уйдет в сеть LAN2 на шлюз 192.168.5.10. При этом пакет будет иметь: адрес источника 192.168.5.1, адрес назначения - адрес в Интернете и MAC-адрес назначения - MAC-адрес внутреннего порта ADSL модема №2 Таким образом, пакет будет доставлен в ADSL модем №2, откуда он, согласно маршрута по умолчанию модема, отправится к провайдеру ISP2.

Посмотрим на соответствующие правила (помечены красным) в листинге таблицы mangle.

В OUTPUT для eth1 есть переход в цепочку 04_GW_INET_MARK.

Там первые три правила, исключают из маркировки исходящий SMTP и DNS трафик.

Это сделано для того чтобы трафик почтового сервера всегда уходил со статичного адреса,

для которого прописана адрес в обратной зоне (.in-addr.arpa), так как очень часто

принимающий SMTP-сервер использует обратную зону для проверки истинности адреса

принимающего SMTP-сервера (Forward-confirmed reverse DNS).

DNS тоже не помечается, чтобы идти через более надежного провайдера ISP1.

Предпоследнее правило в цепочке помечает все новые исходящие от шлюза соеденения (CONNMARK) неким произвольным числом (0x500). Ну и последнее правило уже все пакеты соединений, помеченных этим числом (match 0x500), помечает числом 4 (MARK xset 0x4).

Т.е. помечать надо только трафик, относящийся к исходящим со шлюза соединениям, а весь остальной трафик через eth1 должен остаться нетронутым.

Поток LAN->INET (цепочка 05_LAN_INET_MARK в mangle)

С трафиком LAN<->Internet поступаем также, только в этом случае существует

возможность пометить трафик раньше - еще до первого решения о маршрутизации - в

mangle PREROUTING. Т.о. уже в цепочке FORWARD у помеченных пакетов будет

"правильный" выходной интерфейс источника eth3, а не eth1.

Смотрим листинг (правила помечены синим): там тоже есть исключения.

Первое исключение для подсети 198.51.100.0/30 - эта сеть подключена напрямую к eth1

и трафик в нее всегда должен идти через eth1.

Второе исключение для пользвателя в сети LAN с адресом 192.168.1.3 - ему надо "ходить"

через ISP1.

Третье исключение для сети DMZ - ответный трафик из DMZ должен всегда

уходить через eth1, так как входящие соединения приходят на eth1 (публичный статический адрес).

Четвертое исключение для подсети 192.168.255.0/24, выделенной для клиентов OpenVPN - ответный трафик также должен всегда уходить через eth1, так как openvpn принимает входящие соединения на eth1.

Пятое исключение для RDP (tcp 3389) трафика.

Далее, как и в случае 04_GW_INET_MARK помечаем новые исходящие соединения и уже только помеченные соединенения метим числом для дальнейшей маршрутизации по таблице isp2.

Далее смотрим как идет обратный трафик.

Потоки INET->GW, INET->LAN (цепочки 03_INET_GW, 06_INET_LAN в mangle)

Пожалуй самое примечательное здесь это то, что в filter INPUT могут появляться пакеты вот с такими адресами назначения:

host [361.745891] IN=eth3 OUT= SRC=213.180.204.190 DST=198.51.100.2 LEN=52 TOS=0x08 PREC=0xC0 TTL=55 ID=6076 DF PROTO=TCP SPT=80 DPT=44909 WINDOW=13387 RES=0x00 ACK FIN URGP=0 host [361.917213] IN=eth3 OUT= SRC=217.14.203.229 DST=192.168.5.1 LEN=40 TOS=0x08 PREC=0xC0 TTL=55 ID=38988 DF PROTO=TCP SPT=80 DPT=54684 WINDOW=6456 RES=0x00 ACK FIN URGP=0

Ответные пакеты (рис. 9), приходящие на eth3 подвергаются обратной трансляции адресов и уже после nat PREROUTING и до самых Local Process пакеты будут иметь in=eth3 dst=198.51.100.2.

В процессе маршрутизации исходящего трафика из "общего потока" "вычленяется" трафик, который мы хотим направить через eth3: поэтому "дополнительный поток" (пунктир) появляется только в процессе маршрутизации.

Входящий же через eth1 и eth3 трафик "не сливается" после маршрутизации, так как входные интерфейсы у пакетов остаются разными на всем пути до интерфейса eth0.

С трафиком Internet<->DMZ (на рис. 8 и рис. 9 не показан) происходит то же, что и с трафиком LAN<->Internet, за исключением отсутствия преобразования адресов.

Входящий трафик через двух провайдеров

Рассмотрим для нашей схемы случай, в котором мы хотим принимать входящие соединения на веб-сервер в сети DMZ через два подключения ISP1 и ISP2 одновременно (не путайте этот случай со случаем использования двух каналов (основной+резервный) к одному провайдеру). Это возможно в случае, если клиенты будут подключаться на два разных IP-адреса, принадлежащих разным провайдерам. Пакеты от клиентов, подключающихся на адрес 203.0.113.2, будут проходить через провайдера ISP1 на eth1 и далее через наш шлюз в сеть DMZ. Пакеты от клиентов, подключающихся на внешний адрес модема ADLS №2,будут проходить через провайдера ISP2.

Так как на модеме ADLS №2 включен NAT и публичный адрес присваивается интерфейсу самого моддема, то клиенты, подключающиеся на этот адрес, будут соединяться с модемом, а не с веб-сервером в сети DMZ. Для того чтобы "пробросить" входящие соединение через модем до веб-сервера в сети DMZ, надо на модеме включить и настроить "проброс портов" (port forwarding). С этой функцией входящие соединение на определённый tcp или udp порт модема, будут перенаправляться далее на IP-адрес, в указанный настройке port forwarding'а. Дополнительно в таблице маршрутизации модема надо прописать путь до сети DMZ через 192.168.5.1, иначе "проброшенный" трафик модем будет направлять обратно в Интернет, так как у него этот трафик будет маршрутизироваться согласно маршруту по умолчанию, т.е. обратно через ISP2. Однако одного этого недостаточно для чтобы сервер в сети DMZ мог работать с клиентами, подключившимися через разных провайдеров.